Es gibt viele Artikel, die Ihnen helfen, über die Struktur Ihrer Website nachzudenken, um die User Experience oder das SEO-Ranking zu verbessern. Die meisten von ihnen konzentrieren sich auf Regeln, die zu befolgen sind, und eher empirische Entscheidungsprozesse. Sie sind sehr nützlich, aber es fehlt eine Dimension über die Analyse der aktuellen Situation Ihrer Website und deren Verbesserung.

Wir begannen daher mit der Entwicklung einer Lösung, die es uns ermöglichte, die aktuelle Struktur der Website zu visualisieren und auf diese Weise einen datengesteuerten Prozess zu schaffen, um sowohl die User Experience als auch die SEO-Rankings zu verbessern.

Die User Experience einer Website und SEO hängen von vielen Faktoren ab, wie z. B. dem Design und der Seitenorganisation, aber auch der Architektur der Website, d. h. wie die Seiten miteinander verknüpft sind.

Dies kann bereits über die Struktur der Menüs beurteilt werden, aber ein grosser Teil der Navigation erfolgt auch über Inhalts-Links. Es gibt derzeit keine zufriedenstellende Lösung, die eine vollständige und intuitive Visualisierung dieser Struktur in Verbindung mit Relevanzdaten ermöglicht.

Zeigen Sie mit unserer Lösung die Struktur Ihrer Website in Relation zu Relevanzdaten an

Nach einem ersten erfolgreichen Prototyp beschlossen wir, eine Lösung zu entwickeln, die es unseren Kunden ermöglicht, die Struktur ihrer Website zu evaluieren. Da der tabellenbasierte Ansatz von relationalen Datenbanken nicht hilfreich ist, um das Gesamtbild zu verstehen, bilden wir die Website zunächst auf einer Graph-Datenbank in Neo4j ab. Dies ist nützlich, weil ein Graph eine intuitivere Visualisierung der Struktur der Website und der Beziehungen zwischen den Seiten ermöglicht. Ein wesentlicher Vorteil der Verwendung einer Graphdatenbank ist die Berechnung der Seitentiefe, d. h. der minimalen Anzahl von erforderlichen Klicks, um eine Seite zu erreichen.

Da Neo4j nicht über geeignete Visualisierungsmöglichkeiten verfügt, verwenden wir die Javascript-Library vis.js, um die Netzwerke zu visualisieren. Sie erlaubt es uns, die Darstellung des Graphen einfach anzupassen, die Physik des Modells zu manipulieren und insgesamt die Visualisierung leichter verständlich zu machen und gleichzeitig mehr Informationen darzulegen.

Dieses Framework ermöglichte es uns, unseren Kunden Einblicke zu geben, wie sie die Struktur ihrer Website mit einem datenzentrierten Ansatz verbessern können.

Unsere Website als Beispiel

Um die Privatsphäre unserer Kunden zu schützen, werden wir dieses Werkzeug am Beispiel unserer Website vorstellen. Die Methode bietet Orientierung in unserer kleinen Website und ist in einer Umgebung mit höherer architektonischer Komplexität noch hilfreicher.

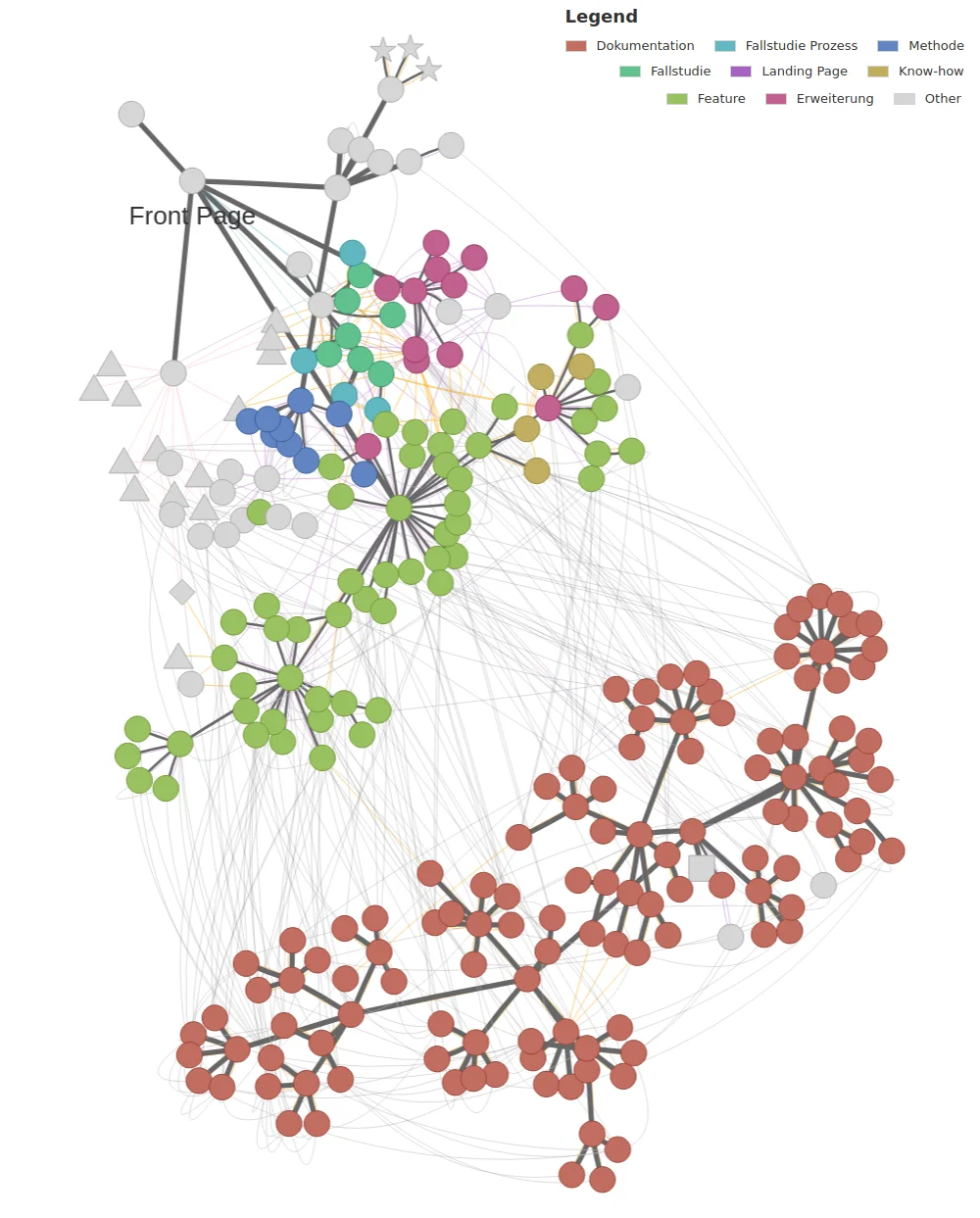

Wir verwenden Formen und Farben, um Informationen auf dem Graphen zu tragen und eine leichtere Orientierung zu ermöglichen. Zum Beispiel können wir einen Seitentyp (gehört zum Blog, ist ein News-Artikel, ein Profil usw.) einer Farbe zuordnen und so die semantischen Strukturen der Website erkennen. Diese sichtbare Struktur kann manchmal mit den verschiedenen Personas der Website in Verbindung gebracht werden.

In unserem Fall hat die Website zwei Hauptbereiche: die Dokumentation, die von der Hauptwebsite getrennt ist, welche hauptsächlich aus unseren Fallstudien, unserem Blog und den Features unserer Plattform besteht. So können wir die Personas "Kunde" und "potenzieller Kunde" klar voneinander trennen.

Auf unserer Website ist es nicht vorgekommen, da sie recht klein ist, aber auf einer der grösseren Websites unseres Kunden kam es vor, dass Cluster von Seiten auf der Website überhaupt nicht erreichbar waren. Da die Seiten immer noch besucht wurden (wahrscheinlich direkt von externen Links), wäre es für unseren Kunden unmöglich gewesen, dieses Problem ohne unsere grafikbasierte Analyse herauszufinden.

Visualisierung von Relevanzdaten

Wir können die Grösse der Nodes an die Anzahl der Besuche zu einem beliebigen Zeitpunkt anpassen. Dadurch können wir Cluster oder Gruppen von über- oder unterbesuchten Nodes auf der Website erkennen. Während Sie mit Google Analytics oder Matomo-Analyse-Tools auf die meistbesuchten Seiten zugreifen können, hat diese Darstellung den Vorteil, dass Gruppen von zusammenhängenden Seiten mit höheren oder niedrigeren Besuchen angezeigt werden. Dies kann mehr Informationen über die Interessenzentren Ihrer Benutzer liefern und Ihnen helfen, Inhalte zu erstellen, die Ihre Benutzer interessant finden.

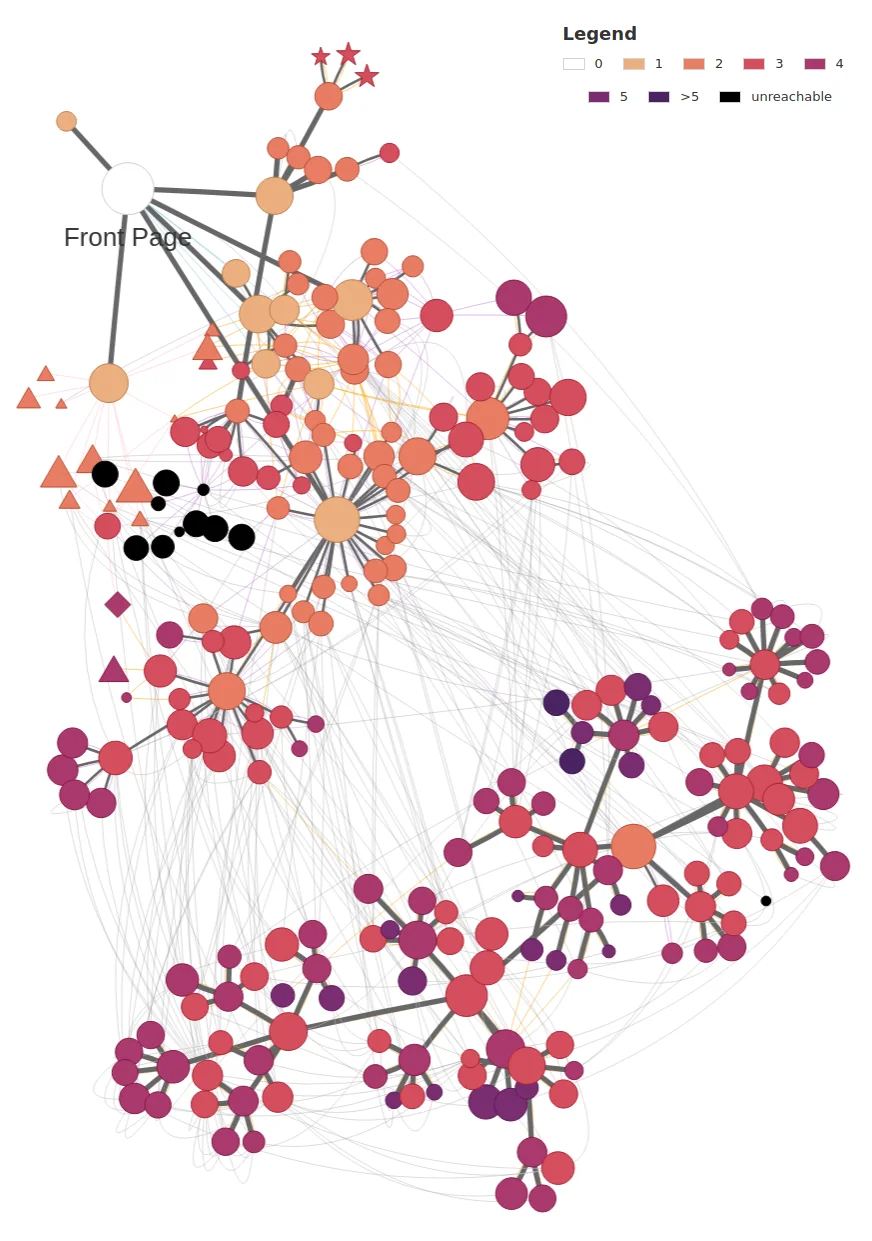

Visualisierung der Seitentiefe in Relation zu Relevanzdaten

Graphen sind auch sehr mächtige Werkzeuge, um den Abstand zwischen Seiten zu berechnen, eine Aufgabe, bei der relationale Datenbanken stark unterlegen sind. Mit Graphen kann dies sehr effizient durchgeführt werden, und das erlaubt uns, die Klick-Tiefe für alle Seiten der Website zu bestimmen. Bei unserer Website konnten wir so zum Beispiel feststellen, dass die ehemalige Frontseite immer noch veröffentlicht - aber unerreichbar war.

Seitentiefenverhältnis zu den Besuchszahlen auf unserer Website. Die Farbe der Punkte ist die minimal erforderliche Anzahl von Klicks, um die Seite von der Frontseite aus zu erreichen. Die schwarzen Punkte sind unerreichbar und umfassen die ehemalige Frontseite der Website und einige wenige Seiten, die nur von ihr verlinkt sind. Mit Hilfe dieser Studie können wir unsere Website verbessern, indem wir die unerreichbaren Seiten löschen und die Benutzer umleiten, und sicherstellen, dass alle wichtigen Inhalte erreicht werden können.

Wenn Sie die Tiefenmetrik mit der Anzahl der Besuche für eine beliebige Seite abstimmen, können Sie Seiten mit wenigen Besuchen erkennen, die sich tief in der Website befinden und somit für die Benutzer schwer zu finden sind.

Darüber hinaus ist es auch möglich, Besuchszahlen zu vergleichen, z. B. zwischen Smartphone- und Desktop-Besuchen, Zeiträume gegenüberzustellen oder sogar herauszufinden, welche Seiten durch Google-Suchen im Vergleich zu direktem Traffic besucht werden.

Was ist mit mir?

Diese Lösung ist bisher auf Websites zugeschnitten, die auf unserer Plattform Primer entwickelt wurden, aber wir arbeiten daran, sie mit einem Crawler zu koppeln, um die Analyse einer beliebigen Website zu ermöglichen. Dies würde aber natürlich nicht die Erkennung von unerreichbaren Seiten erlauben, es sei denn, der Interessent stellt uns eine Liste von zu testenden URLs zur Verfügung.

Wir haben unsere Lösung letzte Woche auf dem DACH-Meetup vorgestellt und sind dankbar für das tolle Feedback. Lesen Sie die Präsentation mit weiteren Darstellungen unserer Website unten.

Wenn Sie daran interessiert sind, dass wir Ihre Website analysieren, zögern Sie nicht, uns zu kontaktieren!